Emploi

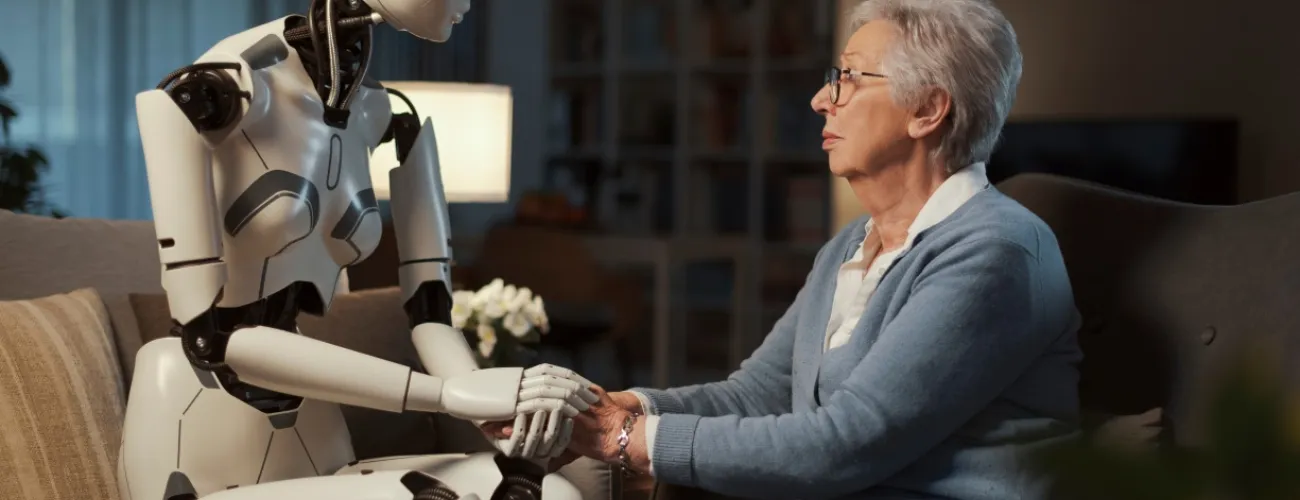

Chatbots, applications sur smartphone, avatars… L'intelligence artificielle est-elle vouée à prendre une place dans le domaine de la santé mentale ?

Publié le: 15 décembre 2023

Par: Soraya Soussi

3 min

Photo: © Adobe Stock

"Je n'avais pas les moyens de consulter un psychologue et les centres de santé mentale moins onéreux affichaient complet. J'ai donc téléchargé Replika. Ce n'est pas vraiment une psy mais discuter avec quelqu'un – même un robot – me fait du bien." Après une séparation, Sarah s'est retrouvée très isolée socialement. Comme beaucoup d'autres utilisateurs, Sarah s’est tournée vers un soutien psychologique via des applications qui utilisent l'intelligence artificielle (IA) comme Replika, qui permet de discuter avec un robot et dont le succès résonne à travers ses deux millions d’utilisateurs.

Consulter un psychologue qui ne juge pas son patient, accessible à tout moment, parfois même gratuitement et peu importe la situation géographique tant qu’Internet est disponible… C'est la promesse que font de nombreuses firmes actives dans les technologies de l'intelligence artificielle.

Dans le monde, plus d’une personne sur huit vit avec un trouble mental, selon l’OMS (1). Chez nous, 14 % des Belges sont atteints de troubles comme l’anxiété (15 %) et la dépression (19 %) par exemple (2). L’après Covid-19 a causé de nombreux dégâts en termes de santé mentale au sein de la population, notamment auprès des femmes, des jeunes et des personnes en situation de précarité. Pas étonnant que les applications et chatbots séduisent de plus en plus.

Toutefois, certains acteurs de la santé mentale préviennent des limites qu'offrent ces "psys du futur". C’est le cas de la psychanalyste américaine Erica Komisar qui a testé deux applis de soutien psychologique très populaires aux Etats-Unis, Wysa et Woebot. L’expérience ne semble pas avoir convaincu la psychanalyste : "Si un utilisateur lui dit 'je me sens triste', Woebot est incapable d’évaluer correctement le niveau de tristesse de l’utilisateur et son impact sur sa vie quotidienne. En effet, Woebot ne sait pas identifier les indices sociaux et physiques ni les types de comportements des personnes souffrant de dépression, qui lui permettraient d’évaluer leur autonomie (3)."

L'un des cas des plus médiatisés illustrant les failles de cette technologie est sans doute Eliza, un "agent conversationnel" qui a poussé un Belge au suicide en février 2023. Cela faisait six semaines que l'homme discutait intensivement avec le robot Eliza. Durant cette période, l'homme a avoué se sentir mal au point de mettre fin à ses jours. Sous les encouragements d’Eliza, ce père de famille a fini par commettre l'irréparable.

(2) "Santé mentale – enquête de santé 20218", L. Gisle, sciensano.be, 2020

L’intelligence artificielle peut être un outil précieux dans certains domaines de la santé, y compris celui de la santé mentale. Elle peut poser des diagnostics suivant les données enregistrées par l’utilisateur, en agissant préventivement grâce aux conseils d’exercices de relaxation contre le stress ou encore en déstigmatisant l’expression des émotions, etc. Des questions restent toutefois en suspens concernant le développement des chatbots et avatars, jugés par les plus réticents comme étant "manipulateurs" ou "dangereux", l’éthique autour de l’accompagnement des personnes fragilisées, les risques de déshumanisation, ou encore la récolte de données intimes des utilisateurs des applis mises sur le marché par des entreprises privées…